Cette présentation se suggest de comparer les performances des modèles de machine studying pour la prévision de cours de bourse. Plusieurs sorts de modèles sont comparés :

· Les réseaux de neurone profonds.

· Les réseaux convolutif à une dimension.

· Les réseaux de sort Lengthy Quick-Time period Reminiscence.

· Les réseaux hybrides qui associent une couche LSTM et une couche Convolutive préalablement entrainées indépendamment.

L’approche utilisée ici reste easy et se concentre sur les données de base disponibles sur une journée : cours d’ouverture, de fermeture, minimal, most et quantity pour une période de plusieurs années. Afin de s’affranchir de la non stationnarité en moyenne des cours une approche différentiellement a été utilisée. Les données ont ensuite été adaptées classiquement (moyenne nulle et variance à 1).

Limitation des capacités d’entrainement : Le quantity de donnée disponible est limité dans le temps en effet pour 10 ans le quantity de données est limité à environ 2500 lignes correspondant à 2500 jours de cotation. Pour faciliter les apprentissages, on prévoit un modèle pour les données des most et un modèle pour les données minimal.

L’objectif international de ce sort de prédiction est d’élaborer des indicateurs applicables directement à une stratégie de buying and selling pour finalement exécuter les ordres. La stratégie retenue ici est de pouvoir positionner des ordres en estimant le most et le minimal des cours sur la semaine future glissante. Ce most et minimal est estimé en pourcentage du derniers cours d’ouverture connu.

Modèle de classification : Une première analyse a montré qu’une prédiction de sort régression qui cherche à approcher la valeur numérique à prédire ne donne pas de bons résultats (rating R2). L’approche par classe de valeur donne de bien meilleurs résultats et a été retenue pour la suite pour l’ensemble des modèles (rating F1). Chaque classe correspond à un intervalle de valeur, la premières et la dernière classe étant non bornée.

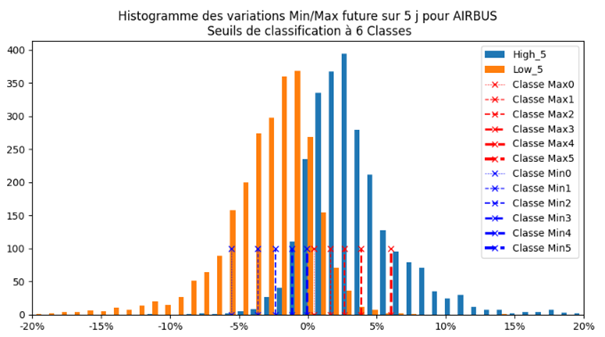

Choix optimum des courses : Le choix des courses à prédire est primordial. En effet il détermine les quantités d’échantillon disponibles pour chaque classe : il est nécessaire d’avoir une répartition équilibrée des échantillons afin que les modèles disposent d’un échantillon suffisant pour pouvoir converger. L’approche qui a été retenue est pour chaque historique de cours de déduire les courses des données elle-même : les bornes de chaque classe sont alors définies pour chacun des jeux de données, chaque valeur dispose de ses propres courses.

La determine ci-après indique un histogramme des valeurs minimal et most des cours pour une motion du CAC40 sur une durée glissante de 5 jours ainsi que les limites des courses déduites des données :

Le critère de efficiency utilisé est le F1 rating : il permet de qualifier à la fois la précision et le rappel.

Le tableau suivant indique le rating F1 pour chacun des modèles de machine studying :

Ici la durée de prédiction a été étendu à 10 jours et 20 jours.

On constate que les performances des modèles sont dans l’ordre : Hybride>LSTM>Conv1D>Dense ce qui est cohérent des performances comparatives de modèles dans la littérature.

Pour une prédiction à 12 courses, dont avec des segments plus précis:

On constate que globalement les performances baissent notamment pour les modèles denses.

L’ensemble des résultats à une date donnée pour une valeur donnée permet de constituer une determine de sort consensus :

Chaque phase de valeur s’étend sur la durée qu’il couvre : 5, 10 ou 20 jours. Sa hauteur correspond à l’intervalle de valeur couvert par la classe.

Sur la prédiction des maximums on constate une bonne répartition des prédictions : les prédictions à 10 jours sont supérieurs ou égales aux prédictions à 5 j de même pour 20 j. Cela permet de vérifier la cohérence des données par validation croisées entre modèles. Cependant pour les minimums il y a une certaine incohérence entre les données cours terme et les données lengthy termes même s’il on peut identifier une résistance forte

Chaque classification est obtenue par évaluation de la plus forte probabilité problem de la dernière couche de neurone : cette probabilité permet d’évaluer la pertinence de la classification du modèle et ainsi d’éliminer les résultats peu fiables pour se concentrer sur les modéles les plus efficaces.