Uno de los pilares fundamentales en todo análisis estadístico y de Ciencia de Datos es el estudio exploratorio de los datos (EDA, por sus siglas en inglés). Antes de aplicar modelos avanzados de Machine Studying, algoritmos predictivos o técnicas de Huge Information, es essential comprender la estructura básica de la información con la que trabajamos.

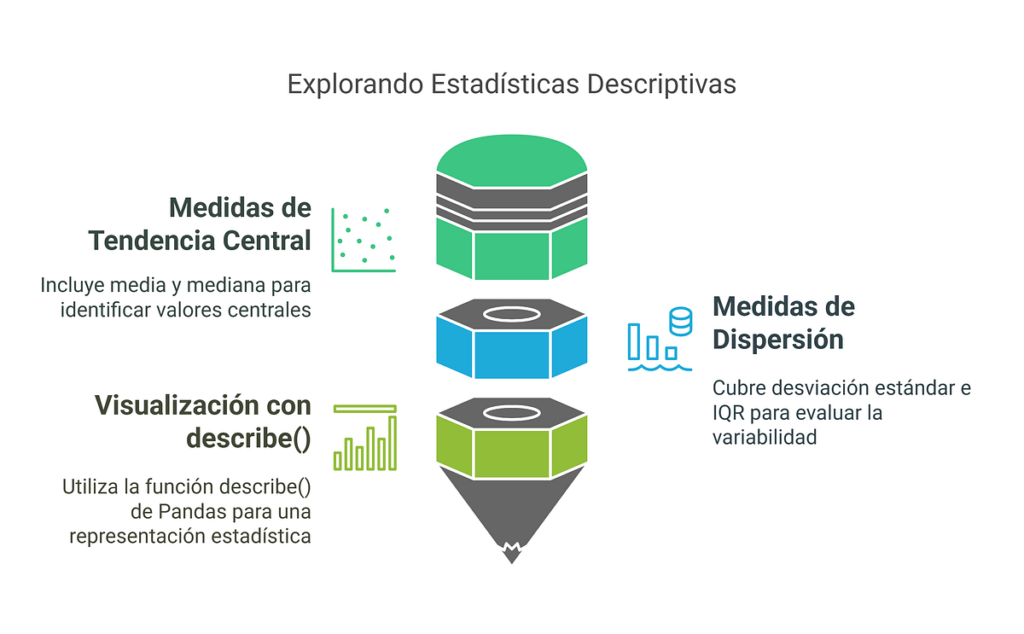

Dentro de este proceso, las estadísticas descriptivas cumplen un papel central: permiten resumir grandes volúmenes de datos en indicadores simples, facilitando su interpretación y guiando la siguiente fase del análisis.

En estadística, las medidas descriptivas constituyen la primera herramienta para:

- Identificar patrones generales en los datos.

- Comparar distribuciones entre diferentes muestras o poblaciones.

- Evaluar si los datos cumplen supuestos necesarios para métodos inferenciales.

- Facilitar la comunicación de resultados a audiencias no técnicas mediante resúmenes claros.

En otras palabras, son el puente entre los datos en bruto y el análisis inferencial o predictivo.

En Ciencia de Datos, donde se manejan datasets masivos y heterogéneos, estas medidas adquieren un valor aún mayor:

- Permiten detectar anomalías o outliers que podrían distorsionar un modelo predictivo.

- Ayudan a elegir la transformación más adecuada (normalización, estandarización, logaritmización, and so forth.).

- Contribuyen a diseñar visualizaciones iniciales que apoyen la toma de decisiones.

- Orientan en la selección de algoritmos: por ejemplo, distribuciones con fuerte asimetría pueden sugerir modelos no paramétricos en lugar de modelos lineales clásicos.

Dicho de otro modo, sin un análisis descriptivo sólido, cualquier modelo de IA o Machine Studying corre el riesgo de estar fundamentado en supuestos equivocados.

Las medidas de tendencia central resumen el valor “típico” o más representativo de una variable.

- Media aritmética (promedio): ampliamente utilizada en estadística inferencial. Es adecuada cuando la distribución es simétrica y no presenta valores extremos. Sin embargo, en datos sesgados (ejemplo: ingresos, tiempos de espera), puede ser poco representativa.

- Mediana: valor que divide a los datos en dos mitades. Es más robusta frente a outliers y una mejor elección en distribuciones asimétricas.

- Moda: aunque menos usada en Information Science, es útil en variables categóricas o cuando interesa identificar valores con mayor frecuencia.

📎Ejemplo en Ciencia de Datos:

En un dataset de salarios, la media puede estar muy influenciada por un pequeño grupo con sueldos extremadamente altos, mientras que la mediana reflejará de manera más fiel la situación de la mayoría.

Si la tendencia central nos cube “dónde están” los datos, las medidas de dispersión nos dicen “qué tan dispersos están” respecto a ese centro.

- Rango: diferencia entre el valor máximo y mínimo. Aunque easy, puede verse afectado por outliers.

- Varianza y desviación estándar: fundamentales en estadística inferencial. La desviación estándar indica cuánto se alejan los datos, en promedio, de la media. Es un insumo esencial en pruebas de hipótesis, modelos de regresión y algoritmos de Machine Studying.

- Rango intercuartílico (IQR): mide la dispersión del 50% central de los datos, lo que lo hace robusto frente a valores extremos.

📎Ejemplo en Ciencia de Datos:

Dos modelos de predicción de ventas pueden mostrar la misma media de error, pero con desviaciones estándar distintas. El modelo con menor dispersión será más consistente y confiable.

En la práctica, los científicos de datos requieren herramientas rápidas para obtener un panorama basic de los datos. En Python, la librería Pandas ofrece la función describe() como un estándar de análisis exploratorio:

import pandas as pd

# Cargar dataset

df = pd.read_csv("information.csv")# Estadísticas descriptivas

print(df.describe())

El resultado incluye:

- depend: número de observaciones no nulas.

- imply: media de los datos.

- std: desviación estándar.

- min, max: valores extremos.

- 25%, 50%, 75%: cuartiles, que permiten interpretar la variabilidad y asimetría.

Este resumen estadístico se convierte en la primera “radiografía” del dataset antes de aplicar modelos predictivos o de clasificación.

Las estadísticas descriptivas son mucho más que un conjunto de fórmulas básicas:

- En estadística, proporcionan los cimientos para el análisis inferencial y la construcción de modelos teóricos.

- En ciencia de datos, se convierten en la primera línea de defensa contra datos mal estructurados, distribuciones engañosas o valores atípicos que pueden comprometer la calidad de un modelo de Machine Studying.

En síntesis, comprender y aplicar correctamente estas medidas es clave para cualquier profesional que aspire a realizar análisis rigurosos y tomar decisiones fundamentadas en datos.

✍️ Si te gustó este artículo, compártelo con tu comunidad. Recordemos que las estadísticas descriptivas son la base del análisis: el primer paso para transformar datos en conocimiento valioso. 🚀